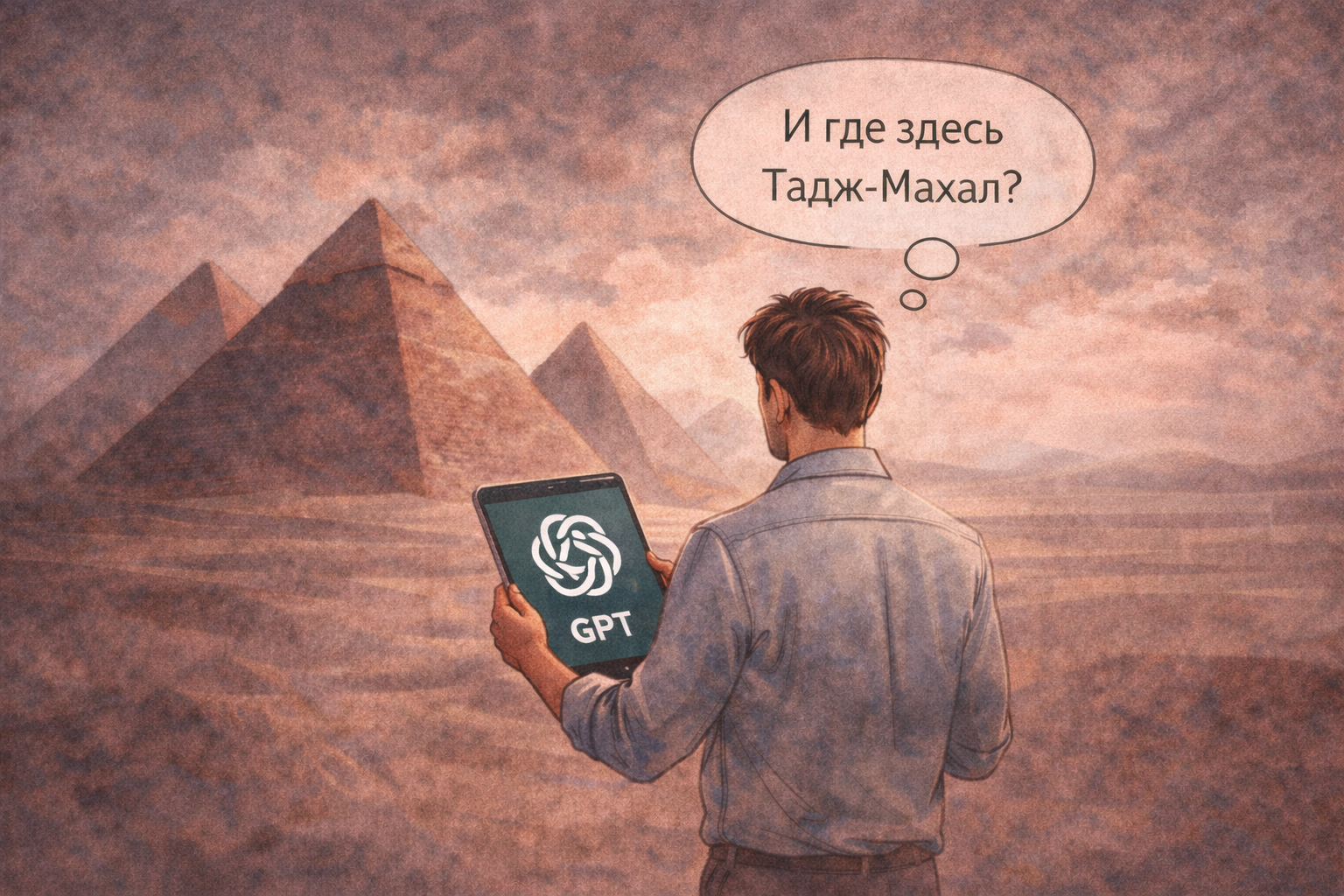

ИИ чаще всего ошибается там, где требуется связь с реальностью здесь и сейчас, ответственность и опора на проверяемые источники. Он формулирует убедительно, логично и уверенно, но не “отвечает за свои слова”. И это важно понимать.

Разберём по сферам, где ломается логика ИИ, почему это происходит и как с этим работать, не попадая в ловушку “чат же сказал”.

Где “ломаются” нейросети

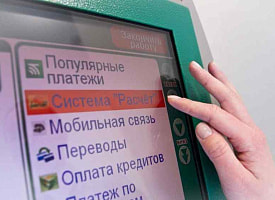

Чаще всего – новости, события, изменения в правилах и законах, расписания, цены, текущие должности, свежие релизы, локальные реалии.

Почему:

Даже при подключенном поиске модель может:

-

опираться на устаревшие данные,

-

смешивать разные версии документов,

-

“достраивать” недостающую информацию,

-

не различать статус “обсуждается” и “вступило в силу”,

-

не видеть paywall или динамический сайт.

Пример:

Запрос “Какие требования к маркировке рекламы вступили в силу в январе?”

ИИ выдает уверенный список пунктов, но часть из них может относиться:

-

к другой стране,

-

к проекту изменений,

-

к предыдущей редакции документа.

Красные флаги:

-

точные даты, цифры и названия документов без ссылок на первоисточник,

-

формулировки “обязательно”, “запрещено”, “вступило” без указания юрисдикции,

-

ответы, похожие на справку, но без следов проверки.

ИИ хорошо пишет “юридическим стилем”, но может:

-

перепутать страны,

-

подменить норму комментарием,

-

“добавить” условия, которых нет.

Пример:

“Можно ли использовать стиль художника X в рекламном визуале?”

ИИ легко проигнорирует:

-

коммерческий характер использования,

-

сходство до степени смешения,

-

условия площадок,

-

риск претензий правообладателя.

Очень скользкая тема для безоговорочного доверия ИИ – здоровье, медицина, психология.

Нейросеть не видит человека, не знает анамнез, а главное – не несёт ответственность. В медицине и психологии важна не средняя вероятность, а исключение худшего сценария.

На конференции “ИИ 2026: рабочие правила, практика и риски” мы целый день разбираем:

-

где ИИ можно доверять,

-

где проверка обязательна,

-

как выстроить работу с нейросетями от понимания до результата.

17 февраля, Минск.

Все ссылки – на сайте конференции.