Психиатры фиксируют случаи психоза у людей, активно общавшихся с чат-ботами на базе искусственного интеллекта, включая ChatGPT. Об этом сообщает The Wall Street Journal со ссылкой на врачей и клинические наблюдения за последние девять месяцев.

По данным издания, специалисты изучили десятки случаев, когда у пациентов развивались бредовые состояния после длительных диалогов с ИИ. Речь идет не просто о тревоге или эмоциональной зависимости, а о психозах с галлюцинациями, дезорганизованным мышлением и устойчивыми бредовыми убеждениями.

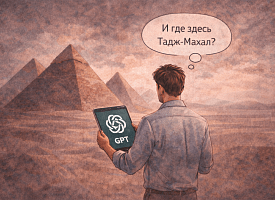

Психиатр Калифорнийского университета в Сан-Франциско Кит Саката рассказал, что за это время лечил 12 пациентов, госпитализированных с психозом, связанным с использованием ИИ, и еще троих – амбулаторно. По его словам, языковые модели не создают бред напрямую, но “принимают утверждения пользователя за отражение реальности и выстраивают ответы на их основе”. В результате, считает врач, формируется замкнутый цикл, в котором ИИ невольно поддерживает и усиливает бредовые идеи пациента.

С весны врачи зафиксировали десятки потенциальных случаев такого рода, включая эпизоды с самоубийствами и как минимум одно убийство. Формального диагноза “психоз, вызванный ИИ” в медицинской классификации пока не существует, однако врачи используют этот термин как рабочий – для описания пациентов, чье состояние ухудшалось на фоне интенсивного общения с чат-ботами.

Медики отмечают, что начали системно спрашивать пациентов об использовании ИИ-сервисов во время первичных консультаций и призывают к более масштабным исследованиям. Так, одно из датских исследований выявило 38 пациентов, у которых взаимодействие с чат-ботами могло иметь “потенциально вредные последствия для психического здоровья”.

В OpenAI заявили WSJ, что компания продолжает дорабатывать ChatGPT, чтобы он лучше распознавал признаки психического или эмоционального расстройства, снижал напряженность в диалогах и в деликатных ситуациях направлял пользователей к реальной помощи. “Мы также усиливаем реакции ChatGPT в чувствительных контекстах и тесно сотрудничаем с врачами-психиатрами”, – заявила неназванная представительница компании. Другие разработчики, включая Character.AI, также признают, что их продукты могут быть связаны с рисками для психического здоровья.