Мемы про искусственный интеллект часто выглядят как невинная ирония. Утюг с интеллектом, который “сам знает”, как гладить. Пылесос, ведущий себя как кот. Но если пролистать чуть дальше смешных картинок, становится ясно: ошибки ИИ давно вышли за пределы чисто бытовых курьезов.

Когда ИИ начинает переписывать историю

В ноябре 2025 года французская прокуратура начала расследование в отношении платформы X из-за комментариев чат-бота Grok, отрицавших Холокост.

Grok опубликовал сообщение на французском языке, в котором утверждалось, что газовые камеры в Аушвице предназначались для “дезинфекции от тифа”, а не для массовых казней. Комментарий был просмотрен около миллиона раз, прежде чем ситуация стала предметом официального разбирательства.

Это пример того, что алгоритм может сгенерировать текст, подпадающий под уголовное законодательство в ряде стран.

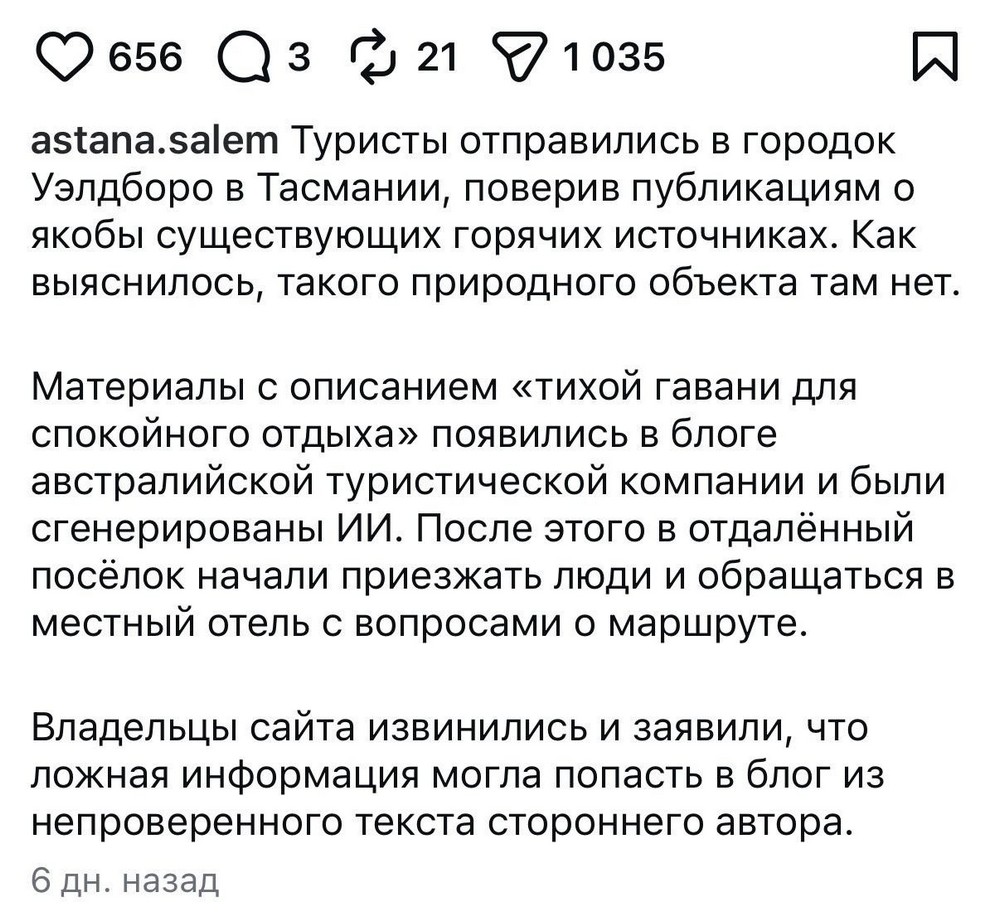

Летний список несуществующих книг

В мае 2025 года Chicago Sun-Times и The Philadelphia Inquirer опубликовали вкладку “Heat Index: Your Guide to the Best of Summer”.

В списке из 15 рекомендованных книг примерно 10 оказались вымышленными. Их названия звучали правдоподобно. Авторы – реальные. Книги – нет.

Среди примеров:

-

Tidewater Dreams – приписана Исабель Альенде;

-

Nightshade Market – якобы Мин Джин Ли;

-

Boiling Point – якобы Ребекки Маккаи;

-

The Last Algorithm – якобы Энди Уира;

-

The Rainmakers – якобы Персиваля Эверетта.

Автор подборки признал, что использовал ИИ и не перепроверил результат. King Features Syndicate уволил его. Газеты удалили материал.

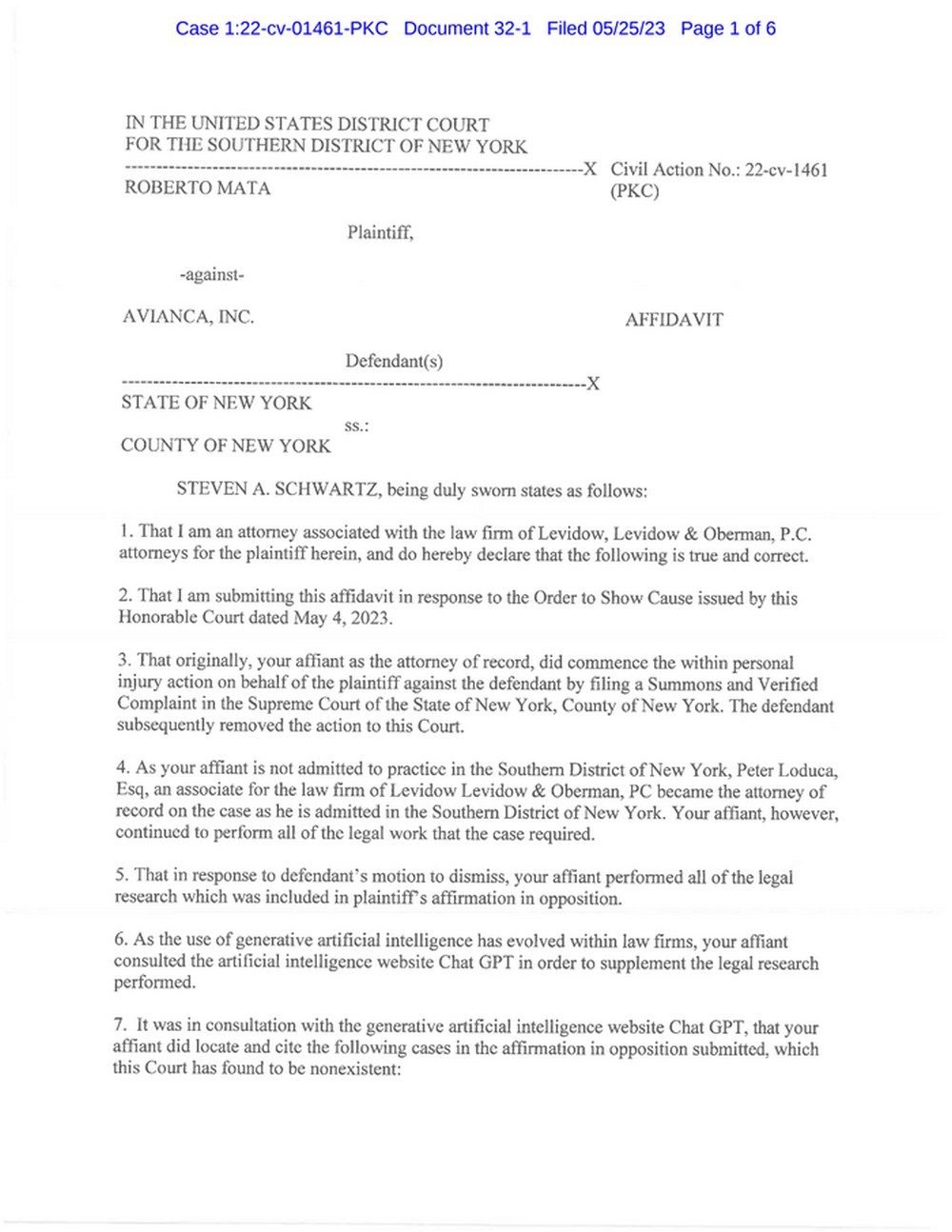

Судебные “прецеденты”, которых не было

Дело Mata v. Avianca, Inc. стало одним из самых известных кейсов галлюцинаций ИИ.

Адвокаты истца, Роберто Маты, использовали ChatGPT для подготовки процессуального документа. Суть иска к авиакомпании Avianca заключалась в том, что Мата якобы получил травму, когда металлическая тележка для подачи блюд в самолете ударила его по колену.

ИИ сгенерировал судебные решения с названиями дел, именами судей и цитатами. Проблема в том, что эти дела не существовали.

Судья Южного округа Нью-Йорка П. Кевин Кастель установил, что как минимум шесть прецедентов были полностью фиктивными. Адвокатов Маты оштрафовали на $5000.

Ложные аресты

Ошибки ИИ становятся особенно заметны, когда они связаны с государственными системами.

В 2020 году в Детройте полиция использовала систему распознавания лиц и ошибочно идентифицировала Роберта Уильямса как подозреваемого в краже. Он провел около 30 часов под арестом, прежде чем стало ясно, что это ложное совпадение.

В Сент-Луисе Кристофер Гэтлин провел более 16 месяцев в заключении после ошибки алгоритма распознавания лиц. Расследования показывают, что задокументировано как минимум восемь подобных случаев в США.

Отдельная проблема – систематическая погрешность в распознавании людей с темной кожей. Исследования, включая отчеты NIST (Национальный институт стандартов и технологий), показывают, что алгоритмы чаще ошибаются при их идентификации.

Роберт Уильямс с семьей. Фото опубликовано Michigan Public

Роберт Уильямс с семьей. Фото опубликовано Michigan Public

ИИ и медиарынок: кто у кого украл

Отдельная линия конфликтов связана с использованием контента медиа. Издание The New York Times подало иск против Perplexity AI, обвиняя компанию в незаконном использовании материалов. BBC потребовала прекратить воспроизведение ее контента. Encyclopaedia Britannica и Merriam-Webster также подали иск, заявив о копировании их текстов. В Японии Nikkei и Asahi Shimbun предъявили претензии по аналогичным основаниям.

Споры касаются масштабного использования текстов для генерации ответов.

Почему это происходит

ИИ не различает факты и вымысел в человеческом понимании. Он строит текст на основе вероятностей. Если структура “выглядит как судебное решение”, модель способна создать его полностью - с номерами, ссылками и цитатами. Если формулировка исторического мифа часто встречается, она может быть воспроизведена как факт.

Алгоритм не проверяет источник. Проверять должен человек.

И где здесь мемы?

Мемы про ИИ смешны, потому что показывают маленькие версии больших проблем.

Когда мы смеемся над тем, что нейросеть “перепутала памятник” или “удалила не тот файл”, мы на самом деле смеемся над логикой ИИ: машина делает статистически вероятные выводы.

Где-то это забавный скриншот. Где-то - судебный штраф или уголовное расследование. И если результат выглядит тревожно, возможно, дело в естественном интеллекте, а не в искусственном?

Автор: Юлия Кочубей

ОБРАТИТЕ ВНИМАНИЕ! 17 февраля мы проводим большую практическую конференцию, посвященную правилам и рискам использования нейросетей. Вы поймете, как модели принимают решения, где они сильны, где ошибаются, почему иногда уверенно врут. Поговорим о теневом использовании ИИ в компаниях и о юридических рисках.

Если вы маркетолог, пиарщик, владелец бизнеса, копирайтер - это точно для вас.