Если загуглите слово “дипфейк”, наверняка наткнетесь как минимум на пару роликов “от имени звезд”. Вот только сами селебрити к этим роликам отношения не имеют: это сгенерированный с помощью ИИ контент. Причем сделано все настолько искусно, что даже намека на фальшь не считаешь. Как распознать в качественном видео и тексте нейроложь? Поговорили об этом в Смартэфире с основательницей проекта aIDeepFake Екатериной Корнюшиной.

Материал подготовлен при поддержке компании Proliv.

Екатерина Корнюшина в видеостудии Смартпресс

Что такое дипфейк? Разбираемся, как нейросети превращают правду в подделку

"Что ни дай в руки человеку – он всегда это может использовать как во благо, так и во вред. ИИ – инструмент высочайшего уровня, может идеально делать одну работу, а может быть и впечатляющей угрозой для людей", – начинает диалог наша гостья. Чтобы разобраться, откуда ждать подвоха, сперва просим пояснить "на пальцах", что же такое дипфейк:

– Дипфейк – это синтез изображения и голоса. Как правило, мы его используем, когда хотим заменить один контент другим. Раньше такую замену делали физически, подключали специалистов по графике, сейчас это могут делать нейросети – буквально за считанные минуты. И именно с тех пор, как в деле ИИ, мы получили доступ к очень качественным, гиперреалистичным дипфейкам, – поясняет Екатерина.

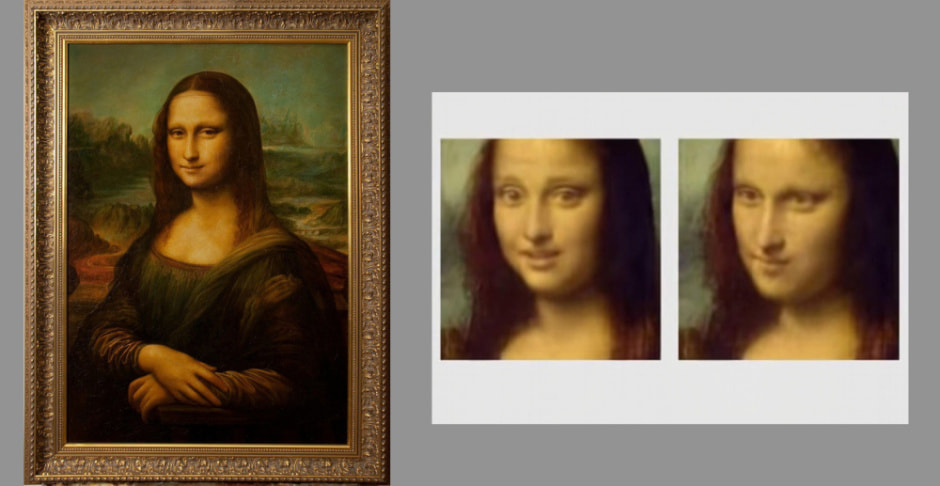

Пример использования дипфейк-технологии в искусстве и медиа – “оживление” персонажей картин или давно ушедших исторических личностей

Пример использования дипфейк-технологии в искусстве и медиа – “оживление” персонажей картин или давно ушедших исторических личностей

По типам фальсифицированный медиаконтент делят на face swapping (полная замена лица), lip sync (реконструкция, в которой изменяется только нижняя треть лица – мимика, движения губ и интонации) и synthetic faces (синтез с нуля несуществующих идентичностей). Это только видеоформаты. В аудио также есть варианты: генерация искусственных аудиоданных из текста (технология TTS) или изменение существующих записей. Про тексты, созданные нейронками, можно и не упоминать – это уже привычная всем технология, которая, впрочем, также отчасти попадает в категорию дипфейков. Наиболее опасно, по мнению эксперта, когда человек получает разноформатную синтезированную ложь: едва ли есть шансы заподозрить неладное.

– В феврале этого года в Гонконге сотрудник крупной международной компании перевел 25 миллионов долларов на счет мошенников – после того, как ему якобы позвонил по видеосвязи его финансовый директор. И голос коллеги, и внешность были абсолютно достоверны! К тому же, накануне и в день сделки между ними была переписка об этой транзакции… Понимаете, как разнопланово подготовились мошенники и какую атаку организовали?

В прошлом году в Арабских Эмиратах тоже был подобный случай: сотрудник банка лишил 35 млн долларов своего клиента по звонку от "руководителя" этой компании. Снова же, акт "развода" был срежиссирован, "прогрет" на всех этапах и, конечно, выполнен идеально качественно, – делится Екатерина Корнюшина.

Первое правило просмотра контента в сети: “Не верь, пока не убедишься в правде!” – говорит героиня интервью

Первое правило просмотра контента в сети: “Не верь, пока не убедишься в правде!” – говорит героиня интервью

Но потеря денег – лишь часть проблемы. Куда более серьезными последствиями могут обернуться репутационные скандалы, когда в подложных видео главы государств и ведомств заявляют то, чего никогда не записывали, когда звезды с мировым именем выступают в сомнительных роликах…

Как бороться с высококачественными подделками?

Противостоять технологии едва ли возможно, запретить – тоже не вариант. А вот иметь инструменты для качественной оценки контента на предмет "правда-ложь" – нужно, подумала Екатерина с командой единомышленников-программистов. И занялась их разработкой::

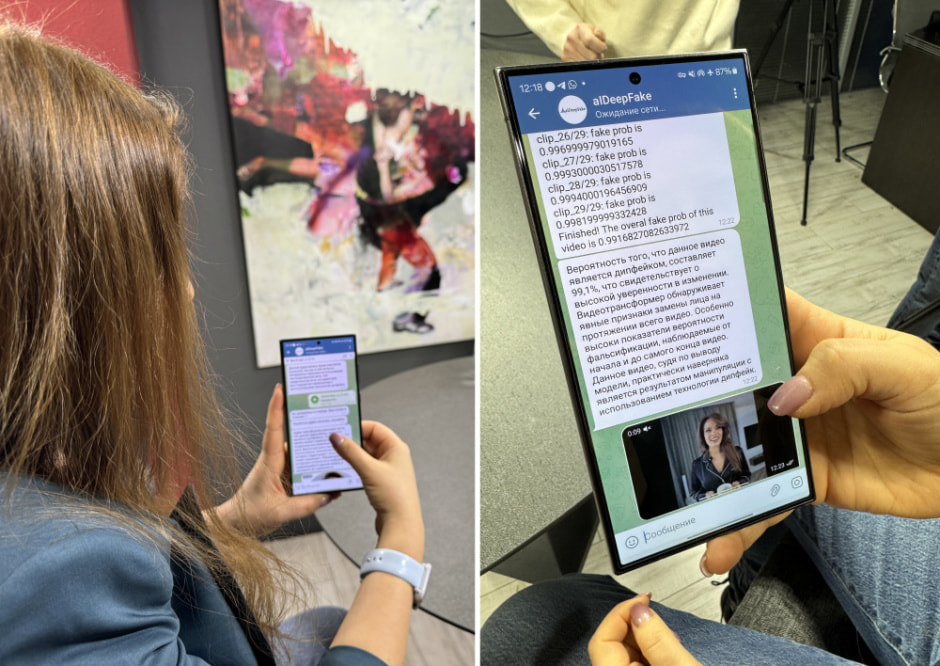

– Мы убедились, что экспертной системы, которая при помощи алгоритмов могла бы выявлять дипфейк, будет недостаточно для столь серьезного "врага", и сделали свою нейронную сеть. Обучили ее на больших объемах данных: и готовых, и дипфейках высокого качества, которые мы создали сами, для анализа. Процент детекции контента (аудиовизуального) у нашей сети очень высокий – порядка 97%. Мы научились определять не только факты синтезированных изменений, но и в каком именно фрагменте они обнаруживаются. Это также важно, потому как часто, чтобы скрыть подлог, фрагмент видео используется настоящий, а после к нему "доделывается" несуществующее продолжение, – поясняет Екатерина.

Авторский детектор сейчас “упакован” в Telegram-бот, которому достаточно несколько минут, чтобы выдать резюме по фото или видео. На фото виден пример ответа от системы

Авторский детектор сейчас “упакован” в Telegram-бот, которому достаточно несколько минут, чтобы выдать резюме по фото или видео. На фото виден пример ответа от системы

Изначально команда пробовала реализовать и опцию анализа текстов, но все доступные алгоритмы пока справились с ней слабовато: в 57% детекции. Так что эту часть решено было приостановить и углубиться в видео. Осенью удалось реализовать и real-time-анализ, который позволяет в режиме прямой трансляции обнаруживать подмену видеопотока на дипфейк. Разработку уже приняли во внимание крупные банки, а также коммерческие структуры с международной командой, где именно посредством видеосвязи зачастую решаются действительно важные вопросы.

– В СНГ на высоком уровне обозначается проблема использования синтезированных фейков. В России сенатор Артем Шейкин стал одним из участников разработки законопроекта о регулировании технологии дипфейка. По этому закону, если в акте мошенничества замечено и доказано использование синтеза контента, наказание ужесточается (увеличивается сумма штрафа или срок). Другой вопрос, что еще нужно постараться, чтобы выйти на след этой фальсификации. Наш инструмент мы еще только внедряем, а пока тем же оперслужбам приходится сутками проводить экспертизы контента на предмет подлога, используя и ИИ, и человеческий ресурс. Все же искусство лжи сейчас на очень высоком уровне.

У медали 2 стороны: чем же дипфейки хороши?

Не все то, что дипфейк, – ложь и угроза. Гостья отмечает колоссальный прорыв в образовательной сфере и в медиамире, как только стала доступна озвучка материала на разных языках без участия человека или ИИ-дубляж киногероев.

Пример ультрареалистичного варианта замены Тому Крузу от ИИ. Видео с сервиса www.youtube.com

Бояться некогда, бороться сложно. Будьте начеку

Екатерина Корнюшина и журналист Смартпресс Ольга Михаленко

Екатерина Корнюшина и журналист Смартпресс Ольга Михаленко

Резюмируя диалог, приходим к выводу: бояться некогда. Эксперт отмечает быстрый рост качестве дипфейков – значительно более интенсивный, чем в части создания “детекторов лжи”. А раз жертвой может стать каждый, следует не забывать о банальных правилах безопасности в сети:

– Многоэтапная аутентификация мессенджеров хоть немного, но защитит персональные данные, чтобы мошенники не получили доступ к ним быстро и просто. А вы понимаете, все ваши голосовые, все "кружочки" видео в телеграм могут быть материалом для "злого творчества". Держите в уме и фишинговые атаки: когда вам присылают какие-то ссылки, особенно не самые близкие люди – и на неожиданные темы, не переходите сразу, подумайте, не может ли это быть обман. К любому видео с запросом помочь финансово или приехать куда-то тоже отнеситесь особо внимательно: не трясутся ли тени, нет ли повреждений в картинке, нет ли контура вокруг лиц? Порой в бытовом мошенничестве какие-то мелочи все же выдают себя. Риск попасться на удочку есть у всех – молодых, взрослых, опытных и не очень. Просто не забывайте об этом, – подчеркивает гостья.

Автор: Ольга Михаленко, фото: Смартпресс

*Использование и цитирование данной статьи допускается в объеме, не превышающем 20% при наличии гиперссылки. Более 20% – только с разрешения редакции.